第2部

AI時代に人間はどうなるのか

モデレーター:小林康夫 パネリスト:中野昌宏*、茂牧人、福田大輔、森島豊、間宮陽介 (*企画責任者)

チューリング・テストと中国語の部屋

- 中野

-

ありがとうございました。今の4人の先生方のコメントの中で共通する部分があったように思います。機械には自由や自発性がない、あるいは感情がないというご意見でした。ただ、これについては、ちょっと危ないというかわからない面があるんです。

例えば、MITのジョーゼフ・ワイゼンバウムが1960年代半ばに開発した「ELIZA」という、カール・ロジャーズが提唱した「来談者中心療法」のパロディー版のプログラムがあります。「来談者中心療法」というのは心理カウンセリング手法の一つで、クライアント(来談者)の話をじっくり聞けば、カウンセラーが主導しなくともクライアント自身が気づいて成長できるという考え方です。知識のストックがさほど要求されないので、話を聞いて「そうなんですね」と返答するような簡単なプログラムをワイゼンバウムが面白半分に組んだんですね。そうしたところ、彼の研究室の助手がELIZAとの会話にハマってしまったんです。

「チューリング・テスト」という、会話の相手が機械かどうか見分けることができるかというテストがあります。けっこう、だまされてしまう。機械と人間が区別できないケースがあるということです。私たちはこうした人間と区別がつかない人工知能を作りつつあるのではないか。それが作れるか作れないか、ということとは別に、倫理的にいいのか?という問題もあります。先ほど森島先生が指摘されたバベルの塔のように、これを「危ない」と感じてしまうのは、できないだろうと思ってはいても、警戒感を持っていて、どこかでできたら困ると思っているためではないかと感じたのですが、いかがでしょう。 - 福田

-

今のワイゼンバウムのプログラムですが、セラピーの場合は、たとえ相手が機械であったり、とんでもない解釈を出してきたとしても、患者さんが自分に関わると思えば自己分析が進むので、相手が機械でも悪くはないんですよね。

- 茂

-

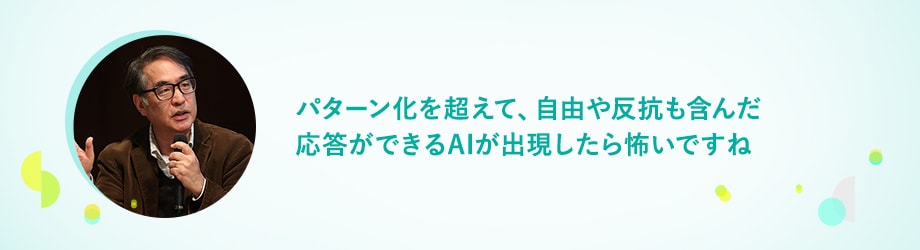

ちょっと質問なんですが、ディープラーニングで大量のデータを読み込ませるのは、こういうときはこうするといったパターンを覚えさせるということですか? でも私は家内と話をしていても、結婚して24年にもなるのに、次の瞬間に家内が何を言い出すか未だにわからない(笑)。他者というのは驚きに満ちていて、パターン化できない問いを出してくるわけですよ。AIはパターンをたくさん覚えていて、その中から答えを引き出してきますが、人間は受験勉強などでパターンをせっせと覚えもするけれど、パターンを超えて、突然旅に出たり、何かの音楽に目覚めちゃったりすることがあるじゃないですか。そんなことはAIにあるんでしょうか? そこをお聞きしたい。

- 中野

-

必ずしもAIにできないわけではなくて……。

- 茂

-

今後はできるかもしれないけれど。少なくとも人間は、原因と結果―原因と結果の繰り返しでつくられているパターン化とは異なって、自由に従うこともできるし、反抗することもできる。まったく別の能力が与えられているんですね。創世記では、神が人間を創造するとき土の塵に息を吹きかけますが、それって、神に従うこともできるし反抗もできるように作った。そういう自由や反抗も含んだ応答は、パターンを覚えるだけの今のAIではできないと思いますが、できたら怖いと思っています。

- 間宮

今の茂先生のお話ですが、AI側に立ってみると、雑音的なコミュニケーションの要素を入れてプログラムすればできるんじゃないですかね。

- 森島

-

先ほどのELIZAへの恋の話は、人間が恋をするということであって、機械が恋をしているわけではないですよね。

- 中野

-

そう断言するのはけっこう難しくて、機械が恋をしているようにも見える。もちろん「ように見える」のと「している」のとでは違うんだけれども、区別できないんです。逆に、人間がAIに恋をするケースは、明らかにありますが。\

- 森島

-

恋ではなく、「依存」と言葉を換えれば、もっとあります。触ると鳴く犬の機械が、高齢女性の心の支えになっていて、その犬の機械が壊れて動かなくなったら悲しくて仕方がないということがありました。人間は応答を求めるので、依存するし、感情も生まれるわけです。例えば私の娘など、Siriに名前を間違えられたら、「違う!」と怒っている。

もちろんAIだって、プログラミング次第で感情が表現できるかもしれないけれど、人間とはレベルというか次元が違う感じがしますね。 - 中野

-

「あたかもそう見える」ことと「真にそうである」ことを判別する難しさについては、強いAIと弱いAIの分類をしたジョン・サールが「中国語の部屋」というメタファーで指摘しています。

部屋の中に、中国語をまったく理解できない人が入っていて、部屋の外から届く中国語の質問カードに答えるというタスクをこなします。意味はサッパリわからないけれど、部屋の中の巨大な辞書を使って、漢字を照合しながら質問に返答していく。こういうやりとりを繰り返すと、部屋の外の人は、中にいる人は中国語を理解していると判断するわけです。でも中にいる人は、単に辞書に従って処理しているだけで、意味を理解しているわけではない。

サールは、この中国語の部屋と同様に、AIもあたかも内容を理解しているかのように応答するだけだとして、強いAIは不可能だと主張しています。

でもこれへのダグラス・ホフスタッターという人の反論もあるんです。例えば、私たちの頭の中に小人が住んでいて、日本語を理解して日本語を返しているわけではないですよね。部屋全体を脳と捉えれば、脳の中は神経細胞のネットワークがあって、そのうちの一部のニューロンが発火するわけですが、今私が話している日本語だって、それを脳の中の小人が理解しているから私が喋れているわけではない。中国語の部屋と一緒ですよね、という反論です。どう思いますか?